全國熱線:010-62104249

地址:北京市密云區高嶺鎮政府辦公樓

王經理 13393261468

Q Q:514468705/1049705527

郵箱:jhcxkj@163.com

一、前言

數據中心守護著企業重要IT設備的運行,如服務器、網絡設備以及存儲設備等,在數據中心支持全球數十億人口上網的同時,也產生大量的機房能耗,因此,勢必要研究具體的機房能效改善對策,才能真正實現節能。對于當前的數據中心管理者來說,必須采用高效率的機房經營方針,才能取得“環保”及“經濟”雙贏的好處。

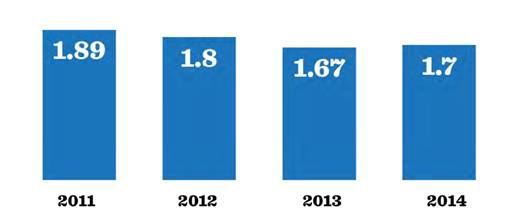

提升數據中心能源效率的第一步,便是審慎評估能源使用效率(PUE,Power Usage Effectiveness),簡單來說,PUE就是數據中心總耗電除以IT設備總耗電,或是數據中心總設施消耗的能源除以IT設備消耗的能源。PUE是由GreenGrid所召集的政府及產業專家組成的項目小組所制定的一項指標,不僅信賴度高,而且可以用來檢驗機房的能源效率,可以廣為適用于一般數據中心,目的是建立一個“一致且可重復使用的衡量指標”,提供數據中心管理者持續監控并改善能耗狀況。根據UptimeInstitute于2014年進行的調查研究顯示,全球業界平均PUE為1.7,高于2013年的1.67,但低于2012年的1.8,表示機房節能仍有改善空間(如圖1)。

圖1:數據中心平均PUE調查,2011-2014

(數據來源:2014數據中心產業調查報告--UptimeInstitute)

受到近年來大數據、物聯網浪潮的推動,各地的機房建設持續進行,同時,在環保意識高漲的氛圍下,“機房節能”也成為了一門新的研究領域。從客觀事實來看,首先,數據中心的電力支出占總持有成本(TCO,TotalCostofOwnership)的一大部分,僅次于人力成本;其次,數據中心常背負著“不環保”的惡名。然而,實際上,以美國為例,數據中心僅消耗了總能源的百分之二,且低于全世界平均值,可見仍有許多機房采用節能手段達到節能減排的目標。

截至目前為止,仍有許多數據中心尚未采用任何效率指標,導致數據中心的節能毫無標準可循。雖然PUE仍存有許多爭議,但是PUE值仍是衡量數據中心基礎設施效率的主要指導方針,而且對于擬定及執行數據中心的綠色節能策略也很有參考價值。

二、數據中心綠色節能策略

根據《自然氣候變化(NatureClimateChange)》發表的一篇論文《低碳數據中心的特征》表示,IT設備如:服務器、存儲設備、通訊技術、基礎設施(風扇、冷卻、水泵、配電等),其本身的效率以及碳排放,是影響數據中心產生溫室氣體的主要因素。這篇論文提出建議,如果專注于能耗改善的部分,將可對數據中心的綠色節能計劃產生顯著的影響。

以下列舉七大數據中心的綠色節能策略,將有助于改善數據中心能耗,并優化PUE。

策略一:定期進行硬件檢查

全球IT巨擘如Facebook、谷歌及蘋果持續投入研發來提升數據中心的效率,他們的做法可能看似很了不起,但是這里所建議的第一個策略是屬于大部分企業都能做到的,就是例行性檢查既有的硬件設備。

數據中心普遍存在許多不必要的IT設備,所謂“休眠的服務器”指的是仍然插在機柜里,實際上卻已不再使用的服務器,但是會占據寶貴的機柜空間,消耗大量能源,并且使PUE惡化。為了了解此問題的普遍性,UptimeInstitute于2013年進行了一項相關調查,發現大約有半數的被調查者并未執行計劃性的檢查及拔除多余的服務器。此外,在美國EPA樣本研究(U.S.EPAsamplestudy)中,大部分機房的現場并無法準確地監控所有基礎設施及IT負載,可見機房節能改善之路還很長。

以總部位于倫敦的英國巴克萊銀行為例,該銀行于2013年拔除了9,124個多余的服務器之后,不僅減少了使用的電力、冷卻和機柜空間,同時并擴大了計算能力以及節省了450萬美金的電費,可見減少服務器的好處非常明顯。

除了IT設備的檢查,對于非IT的基礎設施,也必須做定期的檢核,例如機房的不間斷電源系統(UPS),有別于傳統的工頻單機UPS,當前的趨勢是采用高頻模塊化UPS,為了達到機房節能,選用UPS時應該考慮以下兩大條件:

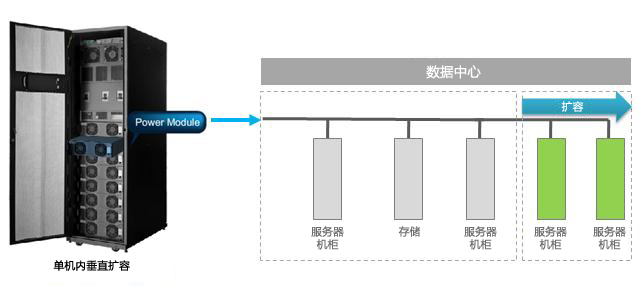

1. 隨需擴容:模塊化UPS可以配合機房擴容的腳步,適時增加電源模塊的數量,不需要在機房建置初期投入大量的資金,并且不占據多余的機房空間,使機房業務逐步成長時,UPS電源仍可“無縫接軌”(圖2);除了增加電源模塊,UPS也必須滿足多機并聯的需求,以因應機房規模擴大的可能性。

圖2 模塊化UPS滿足機房無縫擴容的需求

2. 輕載高效:一般數據中心為了確保可靠度,會配置電源冗余N+X,甚至配置2N雙母線,導致負載率大約在30-40%甚至更低,因此UPS所標榜的“滿載”高效率實際上是不太可能實現的。有鑒于此,市場調查機構Gartner在2013年的報告就指出,除了追求UPS滿載效率之外,也要關注20-100%負載率區間的效率曲線(如圖3),設法達到“輕載高效”的理想境界。以一臺容量200kVA的高效率模塊化UPS為例,考慮數據中心日間和夜間負載率的差異,相較于一般傳統UPS,高效率UPS可以省電5%左右(表1)。

圖3:UPS效率曲線

表1 高效率模塊化UPS與傳統UPS效率比

|

以UPS容量200kVA為例 |

高效率模塊化UPS |

傳統UPS |

單位 |

|

日間供應的電源,負載率50% |

100 |

100 |

kVA |

|

效率差異 |

0% |

4% |

|

|

總能耗 |

100 |

104 |

kVA |

|

日間能耗,假設有14小時 |

1400 |

1456 |

kVAh |

|

| |||

|

夜間供應的電源,負載率30% |

60 |

60 |

kVA |

|

效率差異 |

0% |

7% |

|

|

總能耗 |

60 |

64.2 |

kVA |

|

夜間能耗,假設有10小時 |

600 |

642 |

kVAh |

|

| |||

|

每天的能耗(日間+夜間) |

2000 |

2098 |

kVAh |

|

年度能耗,365天 |

730000 |

765770 |

kVAh |

策略二:例行測量PUE值

如前所述,PUE是量化能源效率的主要業界標準,大部分原因是其具有簡單性及可行性,但是在觀察的幾個行業中卻很少實施。不定期的紀錄并無法確實了解實際的能源使用狀況,所以業內人士不斷建議執行例行性的PUE檢測,以便監測數據中心PUE隨季節變化及其他因素而波動。此外,為了能實時精確量測總電力,并紀錄實際的PUE,必須在關鍵測量點安裝傳感器,并記錄實際電力(kW及kVA),并且應該要記錄一段時期之內的能源使用狀況,才能做出最佳的分析(圖4)。

圖4 PUE值監測儀表板

策略三:更新硬件,提升服務器效率

服務器效率與PUE直接相關,而且是提升PUE的關鍵要素,但是想要正確估計服務器效率,還必須考慮幾個因素。我們可以從CPU利用率出發,針對能效不佳的CPU,虛擬化技術(virtualization)可以大幅提升CPU能效及服務器的效率,而不需要更新服務器;此外,也應該將每一只機柜的負載能力與消耗電力,列入效率的計算中。采用刀片服務器(bladeservers)是提高機柜密度的一種手法(每一機柜最多可容納1,024CPU核心),也可以降低設施的冷卻及電力需求。

將實體服務器合并與虛擬化,將可提高數據中心效率,IT管理人員應該在硬件升級時將此列入考慮。根據研究指出,合并服務器的好處有:

? 平均每年每一服務器最多可節省美金560元

? 減少熱量的產生及相關的冷卻成本

? 釋出多余空間并擴大運算能力

值得注意的是,虛擬化技術及刀片服務器會產生一個負面影響,亦即會產生額外的熱量及冷卻需求。目前有數種解決方案,例如“冷熱通道封閉”或是“機柜式空調(列間空調)”等氣流管理手段,就是為了處理機房高密度負載的問題,請看以下策略四。

策略四:提升機房冷卻效率

冷卻是僅次于IT負載之外,最大的耗電來源,因此,安裝能源監控及測量機制非常重要,可以了解冷卻對于PUE的整體影響與改善的方法。

谷歌已是數據中心節能領域的佼佼者,具有令人稱羨的PUE1.12。在最新的AndroidEmotions報導中指出,最新的谷歌AI產品正在嘗試找出能進一步降低PUE的方法。谷歌更在網志《Efficiency:Howotherscandoit》中,分享了數據中心經理人及經營者可用來降低PUE的五大手法,其中三項與提升機房冷卻效率有關的做法是:

1、優化氣流管理

設計良好的冷熱通道封閉,可避免熱空氣和冷空氣混合,以提升冷卻系統的效率。為了有效排除機房熱點,建立理想的熱能分布狀態,可以借由適當地放置溫度傳感器,利用計算機仿真工具找出熱點并加以排除。根據EPA的研究,有效的冷熱信道封閉系統,可減少25%的風扇能耗,以及20%的冰水主機能耗。

圖5 熱信道封閉技術實例

2、提高機房環境溫度

谷歌已打破了數據中心必須保持約攝氏21℃的迷思,確認了冷通道可以在約攝氏27℃的溫度下運轉,因此在提高溫度的同時,關閉再熱器和除濕機,便可以有效節約能源。

3、采用自然冷卻技術(FreeCooling)

空調系統的冰水主機會消耗大量的能源,可以視天候條件,選用自然冷卻系統,將外面的冷空氣吸進來,加以利用后再排放到外面去。其他自然冷卻的來源包括:引入外界的空氣、水蒸氣或設置大型的熱儲存器。

策略五:提高機房溫度

長久以來,機房IT人員受限于傳統機房溫度的迷思,不太愿意提高機房溫度,然而,美國空調冷凍工程師學會(ASHRAE)最新發布的機房工作溫度建議,范圍修訂為18℃至27℃(64.4°F至80.6°F);除了溫度,ASHRAE也提高了濕度建議范圍。受惠于這樣的修訂,數據中心將可以創造更多冷卻成本的節約,也更能符合自然冷卻的條件。

就機房溫度而言,如果太過保守,維持機房低溫,將會使營運成本居高不下,造成PUE值較差或冷卻成本較高;此外,根據英特爾一項研究數據顯示,機房環境溫度每提升1℃可以帶來4%的制冷成本節約。有鑒于此,一些高溫節能產品就應運而生,舉例如下:

高溫節能服務器:“高溫”是指服務器耐高溫能夠在5℃至47℃環境溫度下,無需空調制冷,能穩定運行,由于服務器能適應更高的機房溫度,而帶來制冷能耗的減少,相對傳統服務器而言,高溫節能服務器具有耐高溫、低能耗、易部署等特點,對于機房節能也是一大功臣。

高溫冰水空調:一般機房內大多是屬于顯熱,只有很少數的潛熱,因此除濕的需求非常少,機房精密空調的入水溫度便可以從一般的7℃往上調升,在此情況下,冰水主機的制冷量增加,能效比改善,也就爭取更多空調節能的機會。

策略六:導入數據中心管理系統(DCIM)

為了協助數據中心經營者更有效、全面地管理數據中心,數據中心基礎設施管理系統(DateCenterInfrastructureManagement,DCIM)就應運而生。DCIM可通過機房鳥瞰圖,協助IT經理人實時應對、事先規劃、管理可能的風險,并減少停機時間。如前所述,個別服務器利用率低是數據中心普遍存在的問題,DCIM可協助數據中心人員找出長期閑置的服務器,加以重新配置,以提升效率,并準確測量數據中心資產及能源的使用狀況。

圖6 數據中心管理系統(DCIM)電視墻與機柜管理接口

策略七:利用純凈的再生能源

百分百純凈的能源是遙不可及的夢想,然而還是有許多企業用的是“混搭”策略來接近此理想目標。舉例來說,包括利用再生能源、就地發電以及遠距電網等等。IT巨擘如蘋果所安裝的55,000片太陽能板、eBay在猶他州Quicksilver工廠利用燃料電池,以及微軟利用風力和太陽能。中小企業或許可以與當地公用事業合作,取得干凈的電力或再生能源,也可在新數據中心選址時,考慮設置在純凈能源公用事業的周邊地區。

三、結論

數據中心綠色節能需要發揮相當的創意,不應受到傳統思維的局限。業界有許多案例均顯示機房節能可以帶來許多實質的好處,而PUE值可以作為一個能效指標的基礎,對于創造永續的綠色數據中心而言是非常重要的。谷歌、Facebook、蘋果及微軟等IT大廠,皆已投資數百萬元進行綠色數據中心的研發,且通過驗證提出綠色數據中心最佳解決方案,能使數據中心的PUE接近理想值。業界一致認為必須全面稽核IT基礎設施以提升數據中心的效率,同時,一般企業可以透過例行測量PUE,以及善用管理工具(如DCIM)找出并修正IT低效率的部分,減少碳排放,提高個別服務器的使用率,最終達到PUE及ROI優化的目標。

編輯:Harris

關鍵詞:ups電源參數http://lbjsjzl.com/list-3-1.html